AWS CodeBuildでGoプロジェクトをビルドする

AWS TokyoリージョンにもCodeBuild等のCodeシリーズ(?)一式揃い、使ってみようということで、まずはCodeBuildを試してみました。

公式にGoのサンプルはあるんですが、他のライブラリ使ってないhello worldなので、CodeBuildの説明だけという感じでした。vendoringが試したいので、今回は昔コンセプト実装したrnbin*1のビルドをCodeBuildに任せる形で試してみました。

つまづきポイントとしては、glideでvendoringしても、cannot find packageになってしまうという点。回避策を書いてくれている方がいましたが、それでも解決せず、詳しく見たらそうかーという感じでした。

全体的なCodeBuild設定の流れ

- ビルドソースを選ぶ(S3, CodeCommit, github) *2

- ビルド方法を指定する(buildspec.ymlを書く or 直接ビルドコードをアップロード)

- ビルド生成物の保存先を指定(S3のバケット+Path)

- ビルド実行!

今回はgithubのpublic repository (rnbin)に、CodeBuild用のbuildspec.ymlを置いています。buildspec.ymlは、まだサンプルなので、featureブランチにpushして、master(default)のブランチにはマージしてない状態です。 このプルリク(色々試したので、コミットがめちゃくちゃ)が対象ブランチ。buildspec.ymlについては、後で説明します。

CodeBuildでBuild Projectを作成する

AWSコンソールから、CodeBuildを開いて、[Get Start] or [Create Project]とするとBuild Projectの作成画面になります。

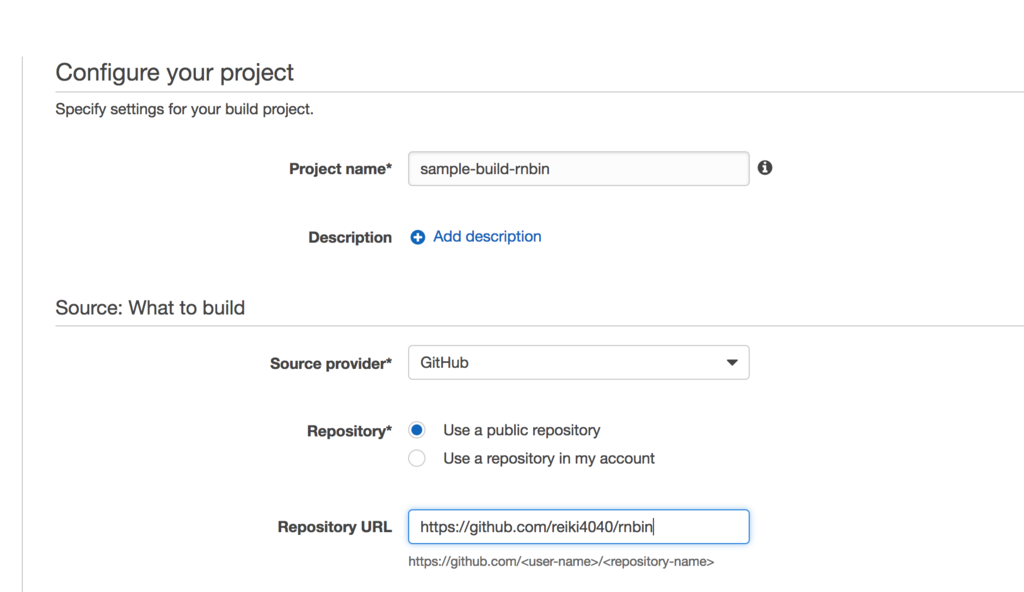

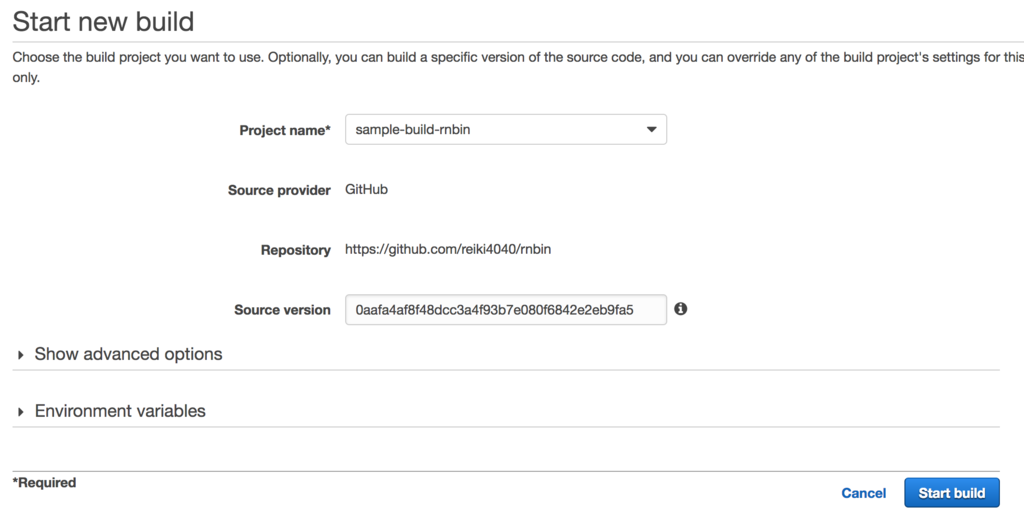

Project nameは任意のものを。今回はsample-build-rnbinにしました。Descriptionは特にないので省略。

次にSourceを選択します。今回はSource Providerにgithubを使います。githubを選択すると、[Connect to Github]と出て、GithubへのアクセストークンをOAuthで求められます。認証し、public repositoryを選んで、https://github.com/reiki4040/rnbinを入れます。

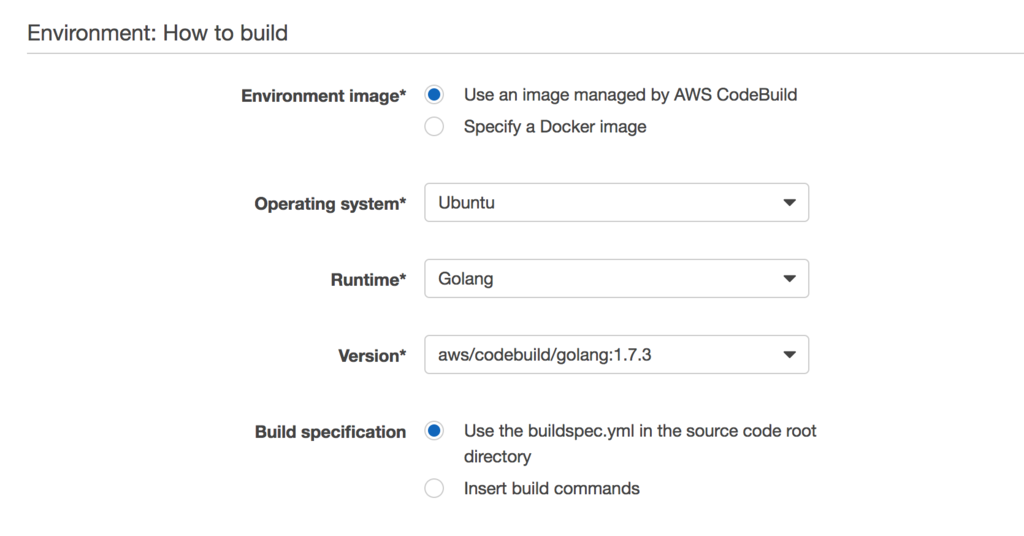

次に、ビルドに使うイメージを選択します。

今回は、Codebuildに用意されているGolangの1.7.3を使いました。Use an image managed by AWS CodeBuildを選び、Operating systemはUbuntu(しかない)にします。Go最新のバージョンだと、docker hubなどから持ってきて使う必要がありますね。

build specificationはリポジトリのbuildspec.ymlを使うので、そのままUse the buildspec.yml in the source code root directoryを。

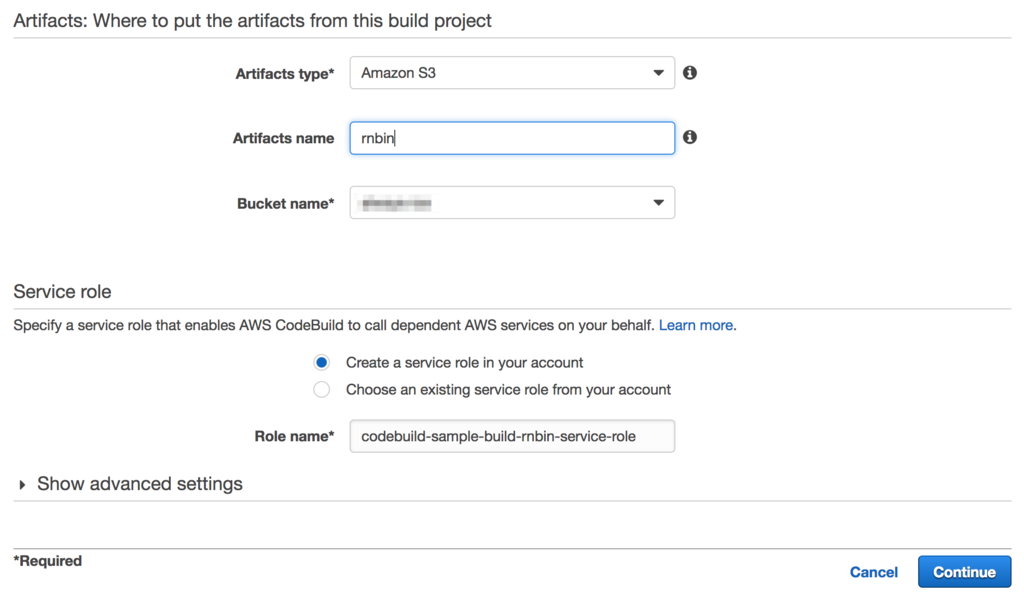

最後に、ビルド後のファイルを置くS3バケットとパスを指定します。

Amazon S3、artifacts nameは、S3のディレクトリになるので、今回はrnbinにします。Bucket nameは任意のS3バケットを選択します。

Service Roleはデフォルトで勝手に作ってくれるので、それに任せます。*3

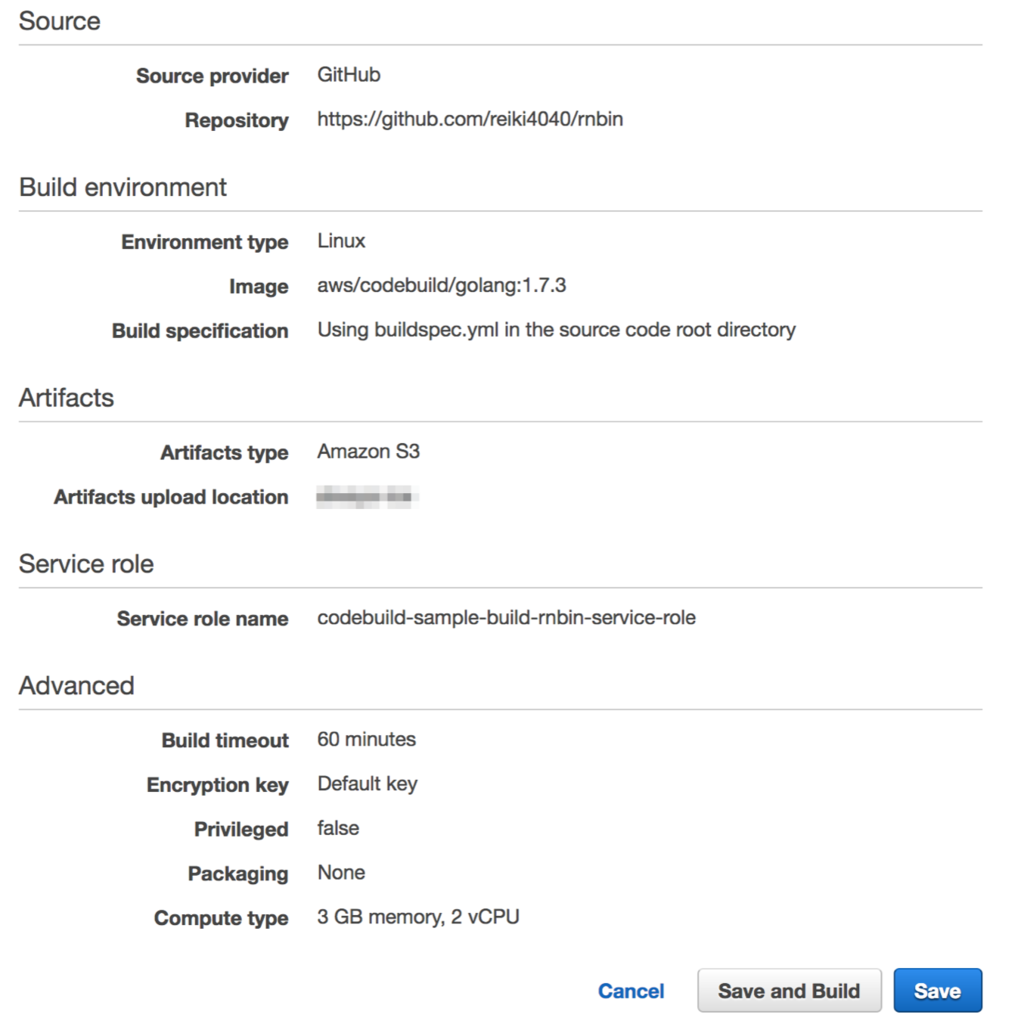

[continue]を押すと、確認プレビューが出ます。Advancedの所は、ビルドマシンのスペックなど選択できますが、今回は省略したのでデフォルトのスペックで動くようになっています。

ビルドする

[Save and Build]を押すと、Build Projectが保存され、Buildが始まり、対象のハッシュを聞かれます。

省略するとデフォルトブランチの最新状態で実行されますが、今回はfeatureブランチの最新のコミットハッシュをコピーしてきて入れます。(画像のハッシュは途中のものなので、最後のものではないです)そして、[Start Build]を押すと開始されます。

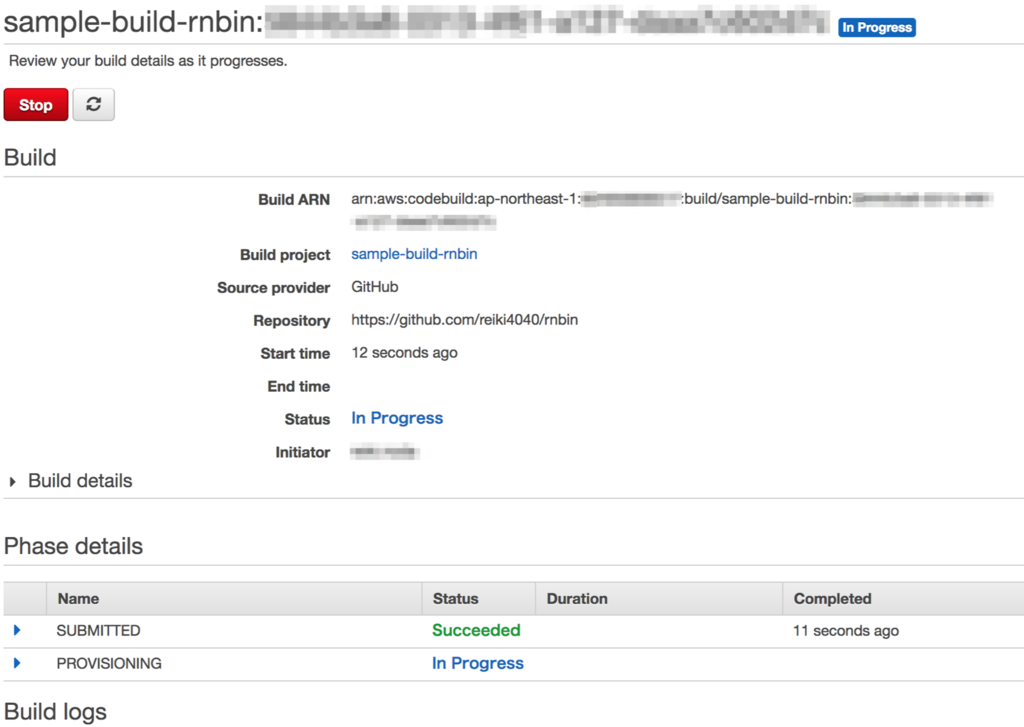

あとは、ビルドのフェーズが着々と進み、In ProgressからSucceededやFailedなどやビルドのログが表示されます。ビルドのログは CloudWatch logsに記録されます。何か問題がある場合はそこを見て判断します。

最後まで成功すると、指定したS3のバケット/rnbin/にrnbinというバイナリが置かれています。*4

buildspec.yml概要と、vendoring回避策

リポジトリのbuildspec.ymlは以下。debug用のpwdとecho $GOPATHも入ってます。

version: 0.1

phases:

install:

commands:

- go get github.com/Masterminds/glide

pre_build:

commands:

# debug

- pwd

- echo $GOPATH

# install libraries

- glide up

# workaround for vendoring

- mkdir -p /go/src/github.com/reiki4040/rnbin

- mv * /go/src/github.com/reiki4040/rnbin/

- mv .git /go/src/github.com/reiki4040/rnbin/

build:

commands:

# workaround for vendoring

- cd /go/src/github.com/reiki4040/rnbin && ./build.sh

post_build:

commands:

# workaround for vendoring

- cp /go/src/github.com/reiki4040/rnbin/rnbin .

artifacts:

files:

- rnbin

buildspec.yml概要

buildspec.ymlに書く内容は、主に4つのビルドフェーズと、ビルド生成物の出力定義(artifacts)です。 ビルドフェーズは以下4つです。

- install

- pre_build

- build

- post_build

必要なツールを入れる、依存解決など、ビルド自体、ビルド後の後始末など、といった感じで、それぞれ複数のコマンドを書けます。

rnbinには、build.shというスクリプトを使って、go buildの流れを実行できるようにしてあります。主にはgitからハッシュやversion、加えてgo versionなどを持ってきてgo buildするという処理が入っています。これをCodeBuildで実行させます。

今回は、glideをインストールして、ライブラリインストール、後述のvendoring回避策をやって、build.shを呼び出し、バイナリを移動させて、S3に保存する。となっています。

vendoringでハマる (回避はしているが、きれいでない)

glideでインストールしたライブラリですが、./vendor/ができているにもかかわらず、cannot find packageと言われてハマりました。使っている環境はgo1.7.3で、go1.5からvendoring ができますが、この機能は$GOPATH以下の場合のみ動作し、それ以外では動作しないとのこと。

試しにpwdとecho $GOPATHで、パスを出してみると、GOPATHには含まれている。

| コマンド | 結果 ※Xの部分はビルドごとに数字変わります。 |

|---|---|

pwd |

/codebuild/output/srcXXXXXXXX/src |

echo $GOPATH |

/go:/codebuild/output/srcXXXXXXXX/src |

エラーを見ると、GOPATH以下のsrcを見ているようで、そもそもrnbin自体に含まれているs3backend packageを読み込めていない。

/usr/local/go/src/github.com/reiki4040/rnbin/s3backend (from $GOROOT) /go/src/github.com/reiki4040/rnbin/s3backend (from $GOPATH) /codebuild/output/srcXXXXXXXX/src/src/github.com/reiki4040/rnbin/s3backend

つまり、currentのパッケージも読めないと。vendorが読めないのは、GOPATH以下ですが、$GOPATH/src/github.com/reiki4040/rnbinという形になっていないのが原因っぽい。そういうことか。

参考にしたページでは、$GOPATH以下に全部コピーして、ビルドする回避策が提示されていましたが、これだと完全には解決しませんでした。

前述の通り、$GOPATHには:区切りで2つ入っているので、そのまま使うとうまく動作していない様子。それなら、/goはまぁ入ってるでしょうと割り切り、$GOPATHを使わず、直接/go/src/github.com/reiki4040/rnbinといったようにコピーして実行していったらやっと通りました。

vendoring回避後のartifactsのファイル指定

生成したものをS3に保存するため、buildspec.ymlのartifactsの所にファイル名を書くんですが、goプロジェクト一式を/go以下にコピーして、ビルドした関係上、そっちに生成されています。

ただ、以下のように指定すると、S3にもそのディレクトリ構造がそのまま残ってしまいました。

artifacts:

files:

- /go/src/github.com/reiki4040/rnbin/rnbin

これはpost_buildのcommandにcp /go/src/github.com/reiki4040/rnbin/rnbin .とcurrentにバイナリをコピーしてくるコマンドを追加しました。commandは1行ずつ独立して実行されるので、.で持って来れます。

これでartifactsの所にはrnbin (生成バイナリのファイル名)のみを指定して、S3にもそのバイナリファイルだけが保存されます。

別ブランチの指定

サンプルだったのでfeatureブランチを使いました。最初はpre_buildにgit checkoutを入れていましたが、start buildでfeatureブランチのハッシュを指定したらfeatureブランチ(というかハッシュのやつ)で落とされたので、不要でした。

まとめ

EC2立てずに、マネージドなサーバでビルドできるところがいいですね。githubじゃなくても、S3にファイルあげてもいいし、CodeCommitにしてもいいので、AWS使ってる人は手をつけやすいかも。vendoringハマりましたが、Jenkins用のインスタンス作って運用するのは手間なので、その点はマネージドの強み。前後の作業も、AWSマネージドでやれるなら便利そうですね。他のCIサービスと比べてどうかは、他やってないのでまだわからず。

glideなどでのvendoringやサブパッケージは、普通に使うと思うので、CodeBuild側でやらなくていいようにしてくれると嬉しいですね。

参考

DeploymentとServiceをyamlファイルで定義する

kubectlコマンドとオプションでnginxをminikube上で動かしました。 今回は、コマンドで起動内容を指定するのではなく、定義ファイルを使って動かすようにします。定義ファイルにすることでgitで管理できるようになります。

コマンドの振り返り

以下のように起動して、接続できるようにしまていました。

# nginxの起動 kubectl run nginx --image=nginx:1.11 --port=80 # Macから接続できるように kubectl expose deploy nginx --name=nginx-nodeport --port=80 --target-port=80 --type="NodePort"

これは実際に何をやっているかというと、Deploymentという機能を使ってnginxコンテナを起動し、Serviceを使ってnginxコンテナにアクセスできるようにしています。

Deployment

Deploymentは、複数のコンテナを並列起動し、世代管理できる仕組みです。今回Deployment(+ReplicaSet, Pod)自体が何かというのはあまり重要ではないので省略。以下の記事で細かく解説されています。

Service

Serviceは複数のコンテナへのアクセスを仲介してくれるロードバランサーです。個々のコンテナのアクセス方法を把握しなくても、Serviceの受付口だけ知っていれば、通信できます。

定義ファイル(yaml)にする

定義ファイルはJSONとyaml形式が使えます。他のプログラムを仲介する場合はJSONが良さそうですが、設定管理なら個人的にはyamlが好きです。(コメントアウトやコメント書ける点が良い)

nginx-deploy.yml

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: nginx

spec:

replicas: 2

template:

metadata:

labels:

run: nginx

spec:

containers:

- name: nginx

image: nginx:1.11

ports:

- containerPort: 80

kubectl runで指定していたもの+を定義します。

| プロパティ | 説明 |

|---|---|

| apiVersion | Deploymentはベータ開発中なので、extentions/v1betaだそうです *1 |

| kind | kubectl runで動かしていたので、隠れていましたが、実態はDeploymentなので明示します。 |

| metadata.name | kubectl runの後に指定していた名前 |

| spec.replicas | --replicasオプションで指定できる、レプリカ数(コンテナの並列数) |

| spec.template. metadata.labels |

識別するための任意のKeyValue |

| spec.template.spec. containers.name |

コンテナの名前 |

| spec.template.spec. containers.image |

--imageオプションで指定していたコンテナイメージ |

| spec.template.spec. containers.ports. containerPort |

--portオプションで指定したコンテナの公開しているポート |

続いてSerivce。kubectl exposeで指定したもの+を定義します

service.yml

apiVersion: v1

kind: Service

metadata:

name: nginx-nodeport

spec:

type: NodePort

ports:

- port: 80

protocol: TCP

targetPort: 80

selector:

run: nginx

| プロパティ | 説明 |

|---|---|

| apiVersion | ServiceはDeploymentと異なりv1です。 |

| kind | 同様にkubectl exposeを使っていましたがServiceを明示します。 |

| metadata.name | --nameオプションで指定していたもの |

| spec.type | --typeオプションで指定していたもの |

| spec.ports.port | --portで指定したいたもの |

| spec.ports.protocol | TCPを明示 |

| spec.ports.targetPort | は--target-portで指定していたコンテナに対するポート |

| spec.selector | 前述のDeploymentのlabelと関係します。後で詳しく。 |

起動

kubectl createコマンドで作成(起動)します。

kubectl create -f nginx-deployment.yml kubectl create -f service.yml

-fは同時に複数指定も可能です。

kubectl create -f nginx-deployment.yml -f service.yml

minikube経由でブラウザ起動して確認。nginxのwelcomeページが見れます。

minikube service nginx-nodeport

DeploymentのlabelとServiceのselector

kubectl exposeコマンドは、その後にdeploy nginxと指定していました。これはnginxという名前

のdeploymentをターゲットにするという意味です。定義ファイルの場合は、labelとselectorで紐付けが行われています。

Serviceのselectorで指定したkey:valueと一致するDeployment*2に、リクエストを流すようになります。

run: nginxを指定していますが、特にrunというkeyにしなくても、Deploymentのlabelをapp: httpserverにして、Serviceのselectorも同様に指定することでもリクエストが流れます。一致すればOKです。

Deployment以外にもlabelやselectorを書けるので、nameよりも柔軟に対象を決めることができるようです。

Labels and Selectors | Kubernetes

いろいろなところで、deploy nginxなど、いちいち名前を書いてられないので、labelをつけて、複数のターゲットを同一label名で識別できるようにすることを目的としているようです。でもlabelは多分もうちょっと詳しく調べないとよくわからず。

参考

- kubernetes - apiVersion and beta versions - Stack Overflow

- Labels and Selectors | Kubernetes

- Kubernetes: Deployment の仕組み - Qiita

*1:http://stackoverflow.com/questions/38547229/apiversion-and-beta-versions

*2:DeploymentじゃなくReplicaSetかもしれない?

Linuxでメモリ使用量が増え続けた

AmazonLinux 2017.03にnginx乗せて稼働させてたら、なぜかメモリ使用量が、1日ちょっとで2GB後半にさしかかりました。cacheではなくusedを徐々に消費してたので、これは何かリークしてる疑い。

プロセス等を見てもメモリを使っているものもいないし、疑いのあるプロセスをrestartしても改善しませんでした。

何だろうなーと調べてみたらすぐ出てきました。特にAmazonLinuxは関係なし。

上記ページと同じく、NSSの問題で、curlがdentryというディレクトリ階層構造の管理をしているキャッシュを多く消費してしまうと。curlでhttpsの監視が動いており、それが5分に1回なので、徐々にリークした様子。1時間に100MB程度ずつ増加していたようです。

回避策は、NSS_SDB_USE_CACHE=YESという環境変数を指定すること。とりあえず監視スクリプトにexport NSS_SDB_USE_CACHE=YESを追加したら、増加が止まりました。

溜まったキャッシュは、以下のようにして解放されました。

echo 2 > /proc/sys/vm/drop_caches

>>でも>でもどっち動きますが多分>の方が適切?2という値は対象のキャッシュによって異なります。

| 値 | クリアする対象キャッシュ |

|---|---|

| 1 | ページキャッシュ |

| 2 | dentry,inode |

| 3 | ページキャッシュ,dentry,inode |

まとめ

じわじわ増えてく系のメモリリークは怖いです。調べたらたくさん出てきたので、割とメジャーな要因みたいですね。

Slabは知らなかったので調べてみたら、ざっくり言うとカーネル側のキャッシュとのこと。細かいメモリ周りはやっぱよくわかってない感。